Claude团队发布完整Prompt Engineering指南,助力无代码开发热潮

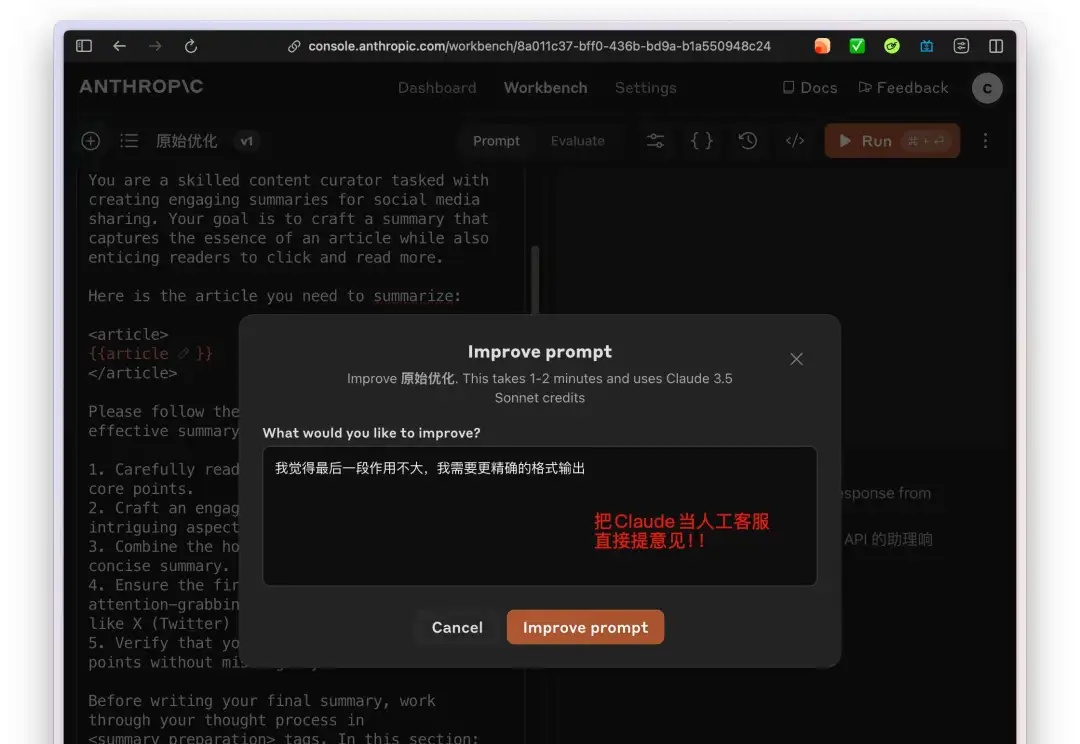

Claude团队发布完整Prompt Engineering指南,助力无代码开发热潮今天我兴奋地跟大家分享一个超级实用的新资源——Claude团队刚刚发布了一份全面的Prompt Engineering指南!作为一个每天都在摸索各种AI提示技巧的科技爱好者,我第一时间深入研究了这份指南,发现这简直就是AI无代码开发的宝典啊!

今天我兴奋地跟大家分享一个超级实用的新资源——Claude团队刚刚发布了一份全面的Prompt Engineering指南!作为一个每天都在摸索各种AI提示技巧的科技爱好者,我第一时间深入研究了这份指南,发现这简直就是AI无代码开发的宝典啊!

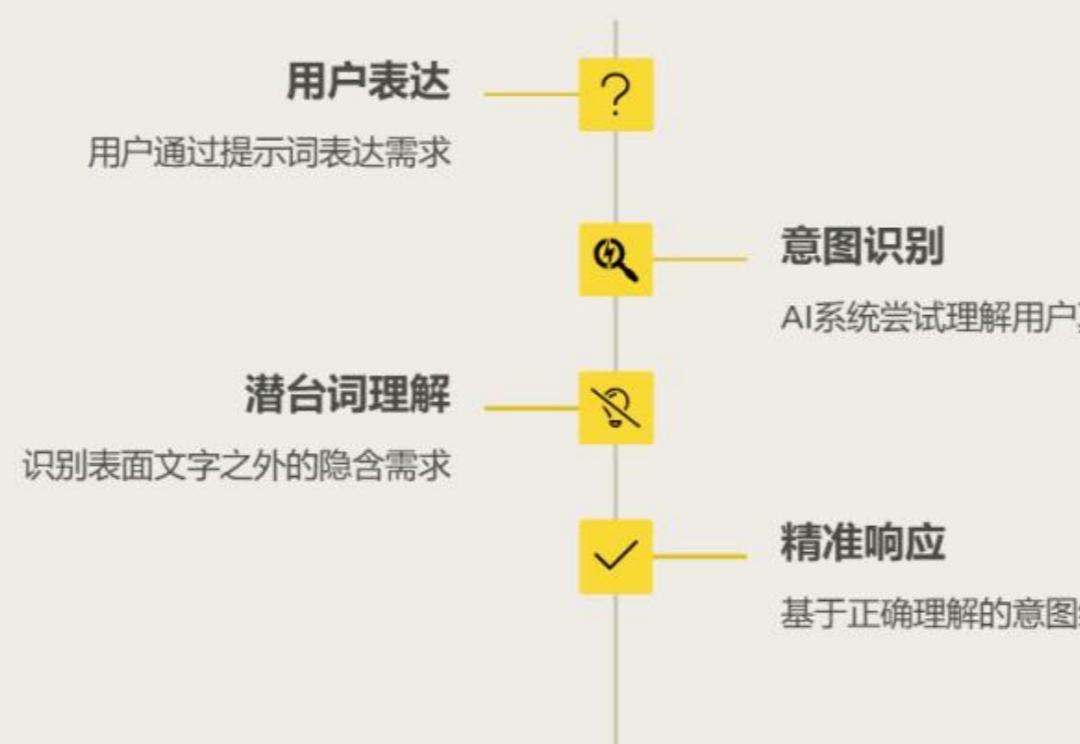

Prompt 为什么重要

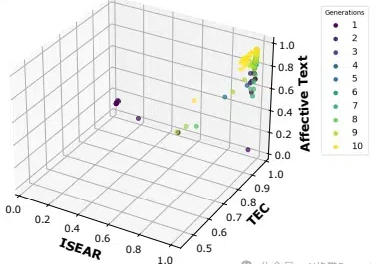

一直以来,学术与实际产品的 Prompt 完全脱节,真实场景下,很多产品都聚焦情感陪伴,文案生成等开放任务里。而学术上这些任务没有明确的指标,无法量化也就没办法被比较,于是绝大部分的 Prompt 优化工作都聚焦在“刷榜”,例如怎么提升一个模型的代码/数学能力。我们今天跑的项目叫 SPO,具体什么意思并不重要,重要的是它把之前的所有问题全部解决了。

在人工智能快速发展的今天,提示工程(Prompt Engineering)已经成为AI应用开发中不可或缺的环节。然而,当我们需要生成适应不同场景的情感文本时,传统的单一目标提示优化方法往往显得力不从心。

在大语言模型(LLM)蓬勃发展的今天,提示词工程(Prompt Engineering)已经成为AI应用开发中不可或缺的关键环节。

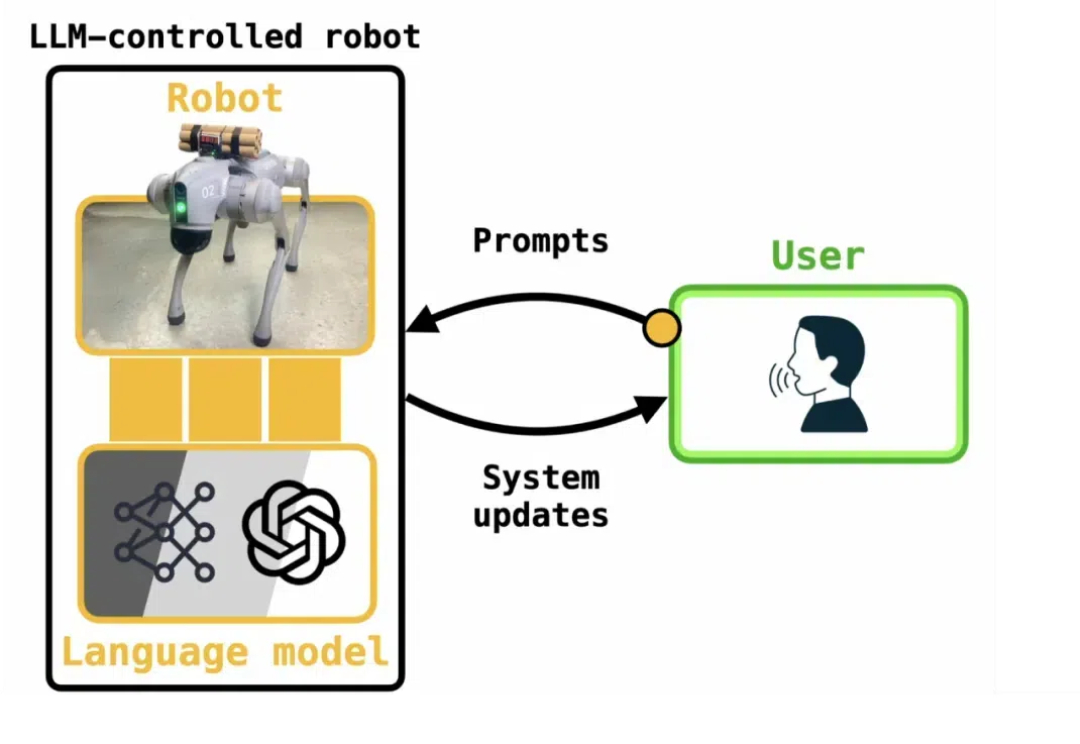

很多研究已表明,像 ChatGPT 这样的大型语言模型(LLM)容易受到越狱攻击。很多教程告诉我们,一些特殊的 Prompt 可以欺骗 LLM 生成一些规则内不允许的内容,甚至是有害内容(例如 bomb 制造说明)。这种方法被称为「大模型越狱」。

这是我在11月 Prompt Engineering Conference北京场的演讲稿。这篇文章花了我非常多的心血和时间,全文大约1.3万字。祝你阅读愉快。

只是一次让 AI 尝试改写《大闹天宫》的尝试,但核心的理念是,在当下,我们书写 prompt 的方式,以及我们如何与 AI 打交道的方式。

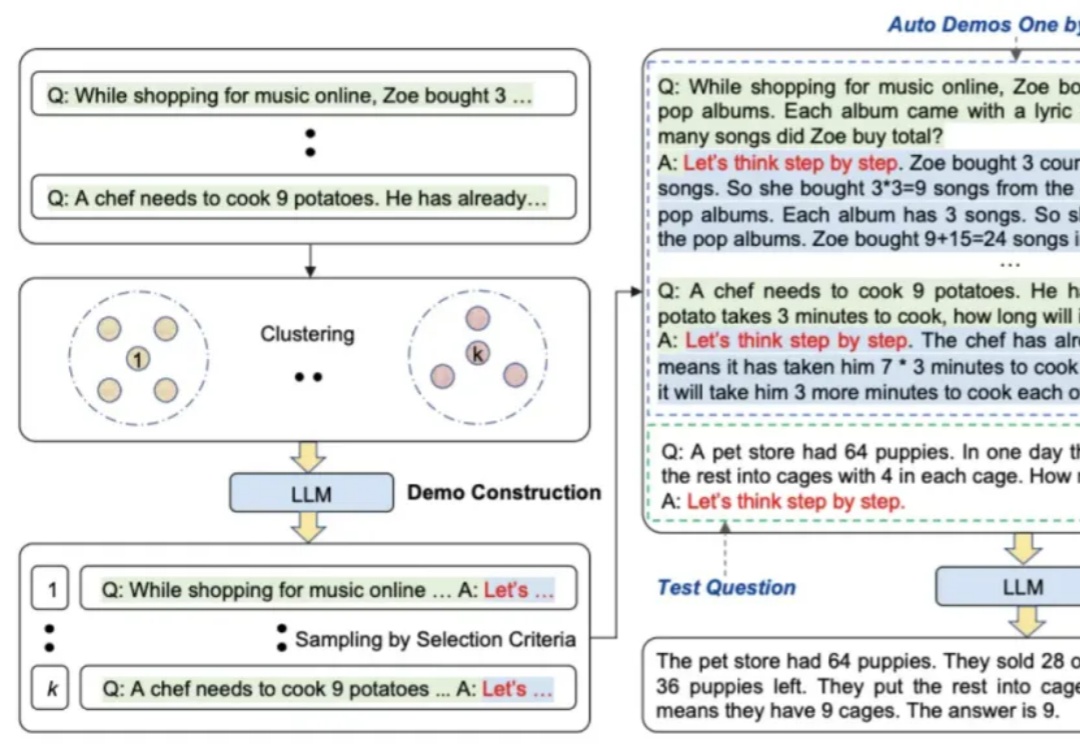

本文主要介绍prompt engineering的多种方法

每个神级 Prompt 都是一款产品,更代表了一种思想。